生成AIの普及が加速する中、企業のAI活用はアシスタント的な利用からエージェント(代理)型へと進化している。人間の代理人として自律的に意思決定を行うAIエージェントの登場により、企業が直面するリスクの性質と規模は根本的に変化しつつある。

プロフィール:大柴 行人

Robust Intelligence共同創業者、Cisco Foundation AIディレクター。高校卒業後、渡米。2019年、ハーバード大学にてコンピューターサイエンス・統計学の学位を取得。大学在学中に、「AIの脆弱性」を研究テーマにAIのトップ会議に複数論文が採択。2019年に当時の指導教授とRobust Intelligenceを創業。セコイア、タイガー・グローバルなどから資金調達し、シスコへ売却。Forbes 30 Under 30に北米・日本両地域で選出。Silicon Valley Japan Platform Executive Committee。デジタル庁先進的AI利活用アドバイザリーボード委員。AIガバナンス協会代表理事。

米国では株主総会の議題に、高まるAIガバナンスへの関心

大柴氏はまず、AIガバナンスについて「AI技術の活用にあたって、企業内でリスク管理、法への対応が必要になる。コーポレートガバナンスの一環としてITガバナンスをこれまでやってきたが、それと同様にAIにもガバナンスが必要」と説明する。

AIガバナンスに対する経営層の関心は高まっている。投資会社のBerkshire Hathaway(バークシャー・ハサウェイ)が株主総会で企業にAIの利用についての監視や管理について経営陣に求める提案があるなど、株主総会の場でAIガバナンスが重要な議題になりつつある。「この傾向は遅かれ早かれ日本にも波及するだろう」と大柴氏は予測する。投資家からAIの活用状況やAIリスクへの対応について質問が当然のように出てくる時代が迫っているのだ。

この変化は、AIガバナンスが従来のリスク管理部やセキュリティ部の範囲を超えた経営課題であることを示している。その重要性から経営課題となり、CISO(最高情報セキュリティ責任者)職が生まれたサイバーセキュリティと同じような道のりをたどっているといえる。

そのAIガバナンスを考えるにあたって、技術と組織の2つからのアプローチが必要と大柴氏は指摘する。技術面では、AIのハルシネーション(幻覚)やデータ漏洩などのリスクがあり、組織面では、それらリスクにどのような組織で対応していくのかを考える。組織では、ガバナンスは通常、第1線(ビジネスユースケースの当事者)、第2線(リスク管理者)、第3線(監査役)と3つのラインで組むことが多いが、AIガバナンスではこの3つのラインをどのように作るのかを考える必要があるという。

AIエージェントは生成AIよりもリスクが大きい

AIガバナンスに取り組むにあたって、まずはリスクを理解する必要がある。経営者が把握しておくべきこととして、AIには技術リスクと社会リスクの2つがある、と大柴氏は整理する。

1つ目の技術リスクは、AIであるがゆえに間違ったことを言ってしまう(ハルシネーション)や、AIの活用によりデータが漏洩してしまうといった、AI技術の制約に起因するもの。技術リスクについては、技術が向上すれば改善されていく可能性もあるという。

2つ目の社会リスクには、学習データの著作権問題、オフショア人材を使ったデータラベリングで不適切な画像や有害コンテンツを低賃金で大量に閲覧・分類させる問題なども含まれる。これらは技術の進歩だけでは解決されず、むしろAIが高性能化すればするほど深刻化する可能性がある。

生成AIのトレンドに追いつくまもなく、AIエージェントの時代に突入しつつある。大柴氏はCIOなど幹部が知っておくべき点として、「AIよりもAIエージェントの方がリスクや脅威は大きい」と警告する。

「これまでの生成AIはコパイロットのように、あくまで助手として人がAIに助けてもらうという使い方だった。これに対して、AIエージェントはその名(エージェント=代理人)の通り、代理人として人間のようにさまざまな意思決定をする」と大柴氏は説明する。このような性質の変化から、アシスタントのリスクよりエージェントのリスクの方が高いとする。

さらに深刻な点として、次のように説明する。「AIエージェントは人間よりも、意思決定のスピードが速く、短時間でより膨大なデータにアクセスしている」。つまり、AIエージェント時代のリスク管理は、従来のリスク管理と比べると脅威のレベルも、規模も大きくなるという。

プロンプトインジェクションだけではない、AIの脅威は?

実際の脅威の例として、プロンプトインジェクション攻撃の実例を挙げる。論文サイト「arXiv(アーカイヴ)」で公開された一部の論文に、高評価するよう指示するプロンプトが仕込まれ、査読AIがそれらの論文を高く評価するといった事例が既に報告されている。

フィッシング攻撃とAIを組み合わせた新たな脅威も見られるという。フィッシングメールの中に、AIにしか分からないようなコマンドが仕込まれており、それをコピーペーストしてAIに入力すると、AIが機密データを取得して外部に送信してしまうといった攻撃手法が現実化している。従来のマルウェアやフィッシング攻撃にAI特有のリスクを組み合わせた新しい形の脅威である。

セキュリティコミュニティであるOWASP(Open Web Application Security Project)では、LLMアプリケーションの脅威トップ10を挙げている。その中には、上記のプロンプトインジェクション、機密情報の漏洩、データおよびモデルの汚染、社内の情報との連携に用いられることが多いRAG(Retrieval-Augmented Generation:検索拡張生成)システムでの埋め込み処理における脆弱性などが挙がっている、と紹介する。

国際的な規制動向:日本は米国と欧州の中間

パワフルな技術であるAIに対して、世界各国では規制を進めている。だが、アプローチは様々だ。大柴氏は米国、欧州、日本の3つのアプローチを分析した。

もともと、規制を作るよりガイドラインや基準を設けるソフトロー寄りだった米国は、トランプ政権の下、さらにその方向性が強まっている。トランプ政権は前政権の大統領令を取り消し、規制緩和の方向に舵を切っている。特にDEI(ダイバーシティ、エクイティ、インクルージョン)関連では、「発言の倫理性を取り締まる部分は、かなり緩くなってきている」と状況を説明した。一方で「セキュリティは、国防とも関連してくるので引き続きかなり投資がされている」という。

対照的なのが欧州だ。欧州連合(EU)のAI規制「EU AI Act」に代表されるように、規制強化の方向性をとっている。EU AI ActはAIシステムをリスクレベル別に分類し、高リスクシステムには厳格な要件を課すもので、2024年に成立し、発効している。段階的に施行が始まっており、今後新しいオープンソースAIモデルを出す際には、安全性や透明性などのチェックが求められる。

両極にある米国と欧州に対して、日本はちょうど良い中間にある、と大柴氏は評価する。2025年に「AI新法」が公布されたが、大柴氏は「日本政府は基本的には研究開発やAIの導入は促進しつつ、リスクへの対応もしっかりする。バランスを取ってAIを利用するというスタンス」と日本のアプローチを説明する。

実は大柴氏がAIガバナンス協会を立ち上げた理由は、このような日本のアプローチを支えるためだという。政府が大枠を決めた後、そこで具体的に何をどのようにチェックをすればいいのか、どのような組織や技術的な仕組みを作ればAIガバナンスを構築できるのかを考えている、と大柴氏は活動の狙いを説明する。

「攻めのAIガバナンス」:活用促進のためのリスク管理

ではAIガバナンスをどのように進めていくべきか。大柴氏が提唱するのは「攻めのAIガバナンス」だ。

「AIを使いたいがどこまで使っていいかわからない、なんとなく怖い、という声を日本企業からよく聞く。このような状況に対して、何が課題となり得るのかの解像度を高め、守るべき部分をしっかり守る。ラインを引くことで、安心してAIを使える」(大柴氏)。

実効性のあるAIガバナンス体制構築のポイントとして、大柴氏は「攻めと守りが同じ部屋にいること。SWATチームのようなものを作って一緒にやることが大切」とアドバイスする。

AI活用するプロジェクトを進めるにあたって、ローンチ準備や議論の段階から、AI、ビジネス、リスク管理、セキュリティなどそれぞれのステークホルダーが参加する。これにより、ビジネスがやりたいこと、AIでできることの議論に、リスク管理やセキュリティの観点からチェックを入れながら進めることができる。その都度チェックするというより、「可視性を確保し、リスク管理やセキュリティチームがプロジェクトを把握できている状態を作る」と大柴氏は強調する。

リスクやセキュリティが最後に入ると、せっかく進めてきたプロジェクトをリスクやセキュリティの観点から終了しなければならなくなる。もし、リスクやセキュリティを無視して推し進めた場合は、深刻なリスクを負うことになる。この点は、既存のソフトウェア開発でセキュリティチームが最初から関わるというやり方を踏襲できる。「新たに仕組みやプロセスを作るというより、既存のものを利用することが成功のポイント。その方がナレッジも溜まりやすい」と大柴氏は指摘する。「たとえば、AIやAIエージェントのPoCを進める際にAIガバナンスを組み込んでやってみる形で進めてはどうか」と助言した。

取り組みを進めるのは、当初はCISOやCRO(最高リスク責任者)など。最終的にはAIガバナンスを専門とする担当者や役職ができることが予想される。

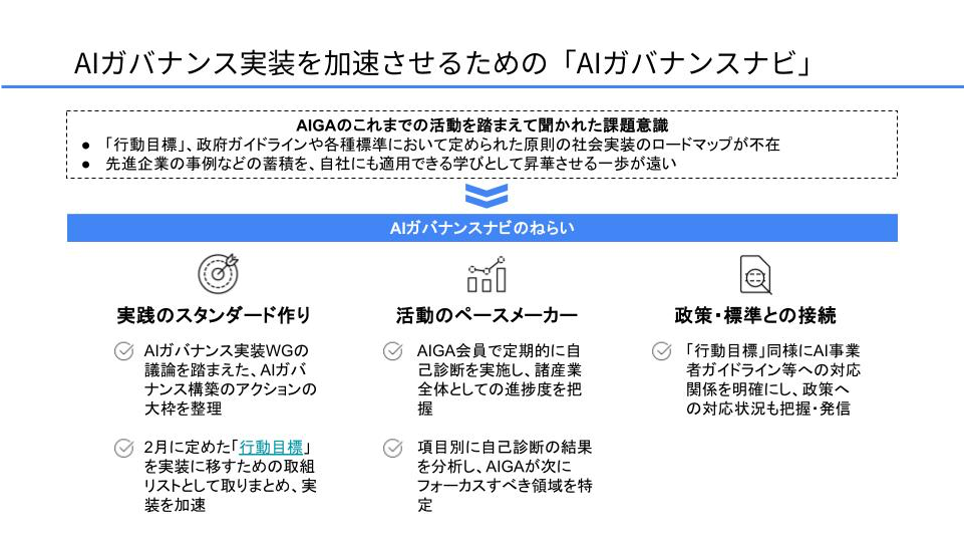

難しい点は、「AIガバナンスはかなり複合的でマルチステークホルダーの領域」と大柴氏。「法律も絡み、プライバシーやサイバーセキュリティとの関わりもある。サプライチェーンの議論もあり、技術的な議論もある」。そこでAIガバナンス協会では社会全体の視点でAIガバナンスのあり方を探っており、取り組み項目として「AIガバナンス行動目標」の策定、実装のための自己診断ツール「AIガバナンスナビ」の開発などを行っている。

トップアジェンダとしての認識を

最後に大柴氏は、CIOや経営層に向けて2つのアドバイスを提示している。

第1に「AIガバナンスやAIのリスクは経営レベルの課題という認識をしっかりと共有する」こと。

AIガバナンスはもはやトップアジェンダだという認識をもち、投資家、取引先、顧客に自社のAI活用におけるガバナンスについて聞かれた時に答えられるようにしておく。「まずは正しい課題の認識を持つことが重要」と大柴氏は強調する。

第2は「AIのユースケースに対して、AIガバナンスをパイロット的に適用する」。これにより、AIガバナンスはAIの活用を抑制するものではなく、促進をする力になることを実感できるだろう、と続ける。そうやってAIのリスクを洗い出し、チェックリストなどを作成していくうちに、成功体験ができてくる。その積み重ねが大切、という。

「AIのリスクについて、ソフトウェアのリスクや組織のリスクなど、部分的に捉える人が多い。だが、AIの可能性を考えると、今後AIリスクは部分的な捉え方を凌駕するものになる」──この認識こそが、AIエージェント時代を生き抜く企業にとって不可欠な出発点となるという。